扫二维码与项目经理沟通

我们在微信上24小时期待你的声音

解答本文疑问/技术咨询/运营咨询/技术建议/互联网交流

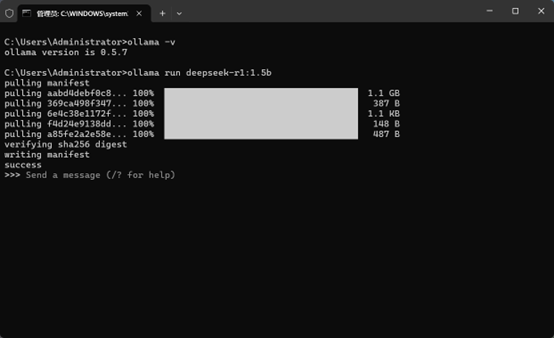

Ollama支持多种大型语言模型,包括DeepSeek。以下是部署DeepSeek模型的详细步骤:

1.选择DeepSeek模型版本:

这里有几个选项:

3.模型安装完成:

4.使用DeepSeek模型:

2.安装ChatBox:

按照安装向导的提示完成安装。

3.配置ChatBox:

4.使用ChatBox与DeepSeek交互:

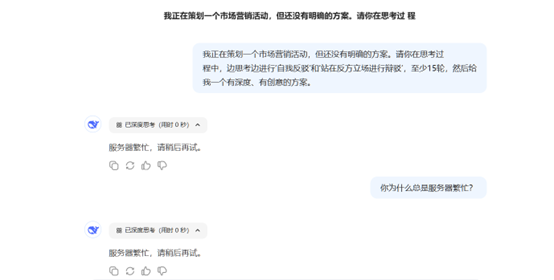

您已经成功在本地部署了DeepSeek模型。无论是使用命令行、ChatBox客户端,您都可以选择适合自己的方式来使用DeepSeek。通过这些简单的步骤,您可以轻松摆脱服务器繁忙的烦恼。

常见问题与解决方案

1. 模型下载速度慢:

2. Ollama安装失败:

3. 模型运行内存不足:

结语

DeepSeek确实是一个强大的工具,尤其是它可以在本地运行,避免了服务器宕机或连接不上的问题。虽然对硬件有一定要求,但像7B这种中等性能的版本,大部分电脑都能顺利运行,完全不需要担心过载卡顿的问题。

总的来说,DeepSeek带给我的体验非常好,能够在本地流畅运行大模型,不仅能节省等待时间,还能减少外部环境的不确定性。

希望这个教程对您有所帮助,让您能够顺利把DeepSeek部署到本地!

如果您有任何问题,别忘了留言告诉我们,让必腾与您一起探讨解决方案吧。

我们在微信上24小时期待你的声音

解答本文疑问/技术咨询/运营咨询/技术建议/互联网交流